llama3.2本地系统+软件安装运行、主要应用、计算硬件要求、最新GPU服务器配置参考

LLaMA 3.2 是 Meta 发布的最新大型语言模型,以下是关于如何在本地安装和运行 LLaMA 3.2 的详细信息,包括硬件配置、系统要求、必要软件、数据源和应用场景。

1. 系统要求

Llama 3.2 工作站/服务器硬件配置指南

2. 必要软件及依赖项

在安装和运行 LLaMA 3.2 之前,需要确保安装以下软件和库:

Step1 Python: 推荐使用 3.8 或 3.9 版本,确保安装 pip 包管理工具。

Stpe2 CUDA 和 cuDNN: 安装适用于你的 GPU 的 CUDA Toolkit(至少 CUDA 11.1+)和 cuDNN 库。

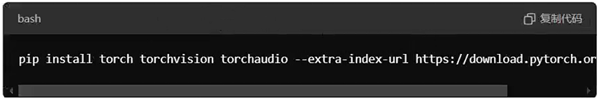

Stpe3 PyTorch: LLaMA 模型依赖于 PyTorch。使用以下命令安装:

Bash

pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu113

请根据你的 CUDA 版本调整命令。

Stpe4 Transformers: Hugging Face 的 Transformers 库,用于处理 LLaMA 模型:

Bash

pip install transformers

Step5 其他依赖项: 可能还需要一些常用库,如 numpy、scipy、pandas 等:

Bash 复制代码

pip install numpy scipy pandas

Step6 DeepSpeed(可选): 如果需要在多 GPU 环境中进行高效推理,可以安装 DeepSpeed:

Bash

pip install deepspeed

3. 模型数据来源

获取 LLaMA 3.2 模型的数据可以通过以下途径:

- 官方发布: 通常在 Meta 或相关官方渠道下载,可能需要注册并接受使用协议。

- Hugging Face: 可能会有一些预训练模型和权重文件上传到 Hugging Face 的模型库。

- 开源社区: 关注 GitHub 和其他开源平台上的相关项目,有可能会有社区成员分享模型权重和代码。

4. 安装位置

建议将模型权重和相关文件存放在如下位置:

- 模型文件: 推荐存放在独立的文件夹中,例如 /path/to/llama_models/。

- Python 虚拟环境: 使用虚拟环境(如 venv 或 conda)来管理依赖项,以避免与其他项目的冲突:

Bash

python -m venv llama_env

source llama_env/bin/activate

pip install -r requirements.txt

- 数据集: 根据应用场景下载不同的数据集,可以放在 /data/ 目录下。

5. 主要应用

LLaMA 3.2 可以应用于多种自然语言处理任务,包括但不限于:

- 文本生成: 用于生成连贯的自然语言文本,如聊天机器人、写作助手等。

- 问答系统: 处理用户问题并提供准确的回答。

- 文本摘要: 提供文档或文章的简要概述。

- 机器翻译: 实现不同语言之间的翻译。

- 情感分析: 分析文本的情感倾向。

- 对话系统: 构建智能对话机器人。

6. 安装步骤总结

- 准备硬件和操作系统环境: 确保有适当的硬件配置和软件环境(如 CUDA、cuDNN、PyTorch)。

- 安装依赖库: 安装所需的 Python 包和库(如 Transformers)。

- 下载和配置模型权重: 从官方渠道或 Hugging Face 下载模型权重文件,放在指定目录。

- 运行测试脚本: 验证模型是否能够正常加载和推理。

希望这些信息能够帮助你顺利安装和运行 LLaMA 3.2。如果你有进一步的问题或者需要更多细节,欢迎随时询问!

我们专注于行业计算应用,并拥有10年以上丰富经验,

通过分析软件计算特点,给出专业匹配的工作站硬件配置方案,

系统优化+低延迟响应+加速技术(超频技术、虚拟并行计算、超频集群技术、闪存阵列等),

多用户云计算(内网穿透)

保证最短时间完成计算,机器使用率最大化,事半功倍。

上述所有配置,代表最新硬件架构,同时保证是最完美,最快,如有不符,可直接退货

欲咨询机器处理速度如何、技术咨询、索取详细技术方案,提供远程测试,请联系

UltraLAB图形工作站供货商:

西安坤隆计算机科技有限公司

国内知名高端定制图形工作站厂家

业务电话:400-705-6800

咨询微信号:100369800